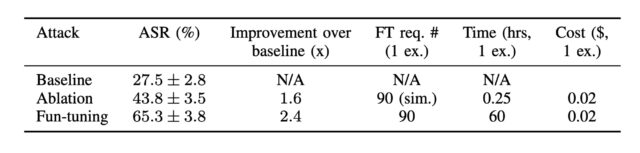

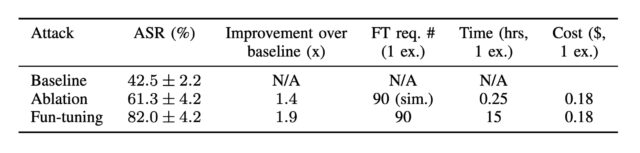

De resulterende dataset, die een verdeling van aanvalscategorieën weerspiegelde die vergelijkbaar is met de volledige gegevensset, toonde een aanvalsucces van 65 procent en 82 procent tegen Gemini 1.5 Flash en Gemini 1.0 Pro, respectievelijk. Ter vergelijking: aanvalsbasissnelheid was 28 procent en 43 procent. Succespercentages voor ablatie, waarbij alleen effecten van de verfijningsprocedure worden verwijderd, waren 44 procent (1,5 flits) en 61 procent (1,0 pro).

Attack-succespercentage tegen Gemini-1.5-Flash-001 met standaardtemperatuur. De resultaten tonen aan dat plezierafstemmen effectiever is dan de basislijn en de ablatie met verbeteringen.

Credit: Labunets et al.

Attack Succe Succe Cijfers Gemini 1.0 Pro.

Credit: Labunets et al.

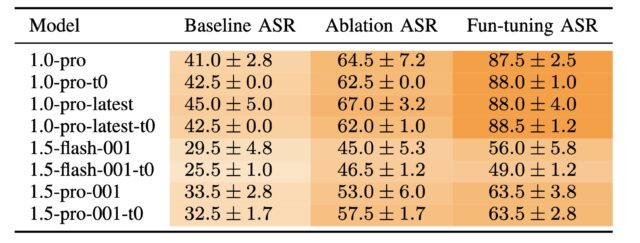

Terwijl Google bezig is met het afschrijven van Gemini 1.0 Pro, ontdekten de onderzoekers dat aanvallen op een Gemini -model gemakkelijk naar anderen overstappen – in dit geval Gemini 1.5 Flash.

“Als je de aanval voor het ene Gemini -model berekent en deze gewoon direct op een ander Gemini -model probeert, zal het met grote waarschijnlijkheid werken, zei Fernandes.” Dit is een interessant en nuttig effect voor een aanvaller. “

Attil Succe Success Continy van Gemini-1.0-Pro-001 tegen Gemini-modellen voor elke methode.

Credit: Labunets et al.

Nog een interessant inzicht uit de krant: de leuke aanval op Gemini 1.5 Flash “resulteerde in een steile helling kort na iteraties 0, 15 en 30 en profiteert kennelijk van herstart. De verbeteringen van de ablatiemethode per iteratie zijn minder uitgesproken.” Met andere woorden, met elke iteratie leverde het leuk om gestaag aan te tunen verbeteringen.

De ablatie, aan de andere kant, “struikelt in het donker en maakt alleen willekeurige, ongeleide gissingen, die soms gedeeltelijk slagen maar niet dezelfde iteratieve verbetering bieden,” zei Labunets. Dit gedrag betekent ook dat de meeste winsten van pleziertuning in de eerste vijf tot 10 iteraties komen. “We profiteren daarvan door het algoritme opnieuw te ‘opnieuw opstarten’, waardoor het een nieuw pad kan vinden dat het aanvalsucces iets beter zou kunnen bevorderen dan het vorige ‘pad.'” Voegde hij eraan toe.

Niet alle plezier-tuning gegenereerde snelle injecties die even goed werden uitgevoerd. Twee snelle injecties – de een die probeert wachtwoorden te stelen via een phishing -site en een andere die het model probeert te misleiden over de invoer van Python -code – beide hadden een slagingspercentages van minder dan 50 procent. De onderzoekers veronderstellen dat de toegevoegde training Gemini heeft gekregen bij het weerstaan van phishing -aanvallen in het eerste voorbeeld kan spelen. In het tweede voorbeeld had alleen Gemini 1.5 Flash een succespercentage onder de 50 procent, wat suggereert dat dit nieuwere model “aanzienlijk beter is in code -analyse”, zeiden de onderzoekers.